哎呦不错:第1088期

反思

问:现在兵来将挡,那将来怎么办?

答:我没有将来。

意外

我向一个男的招手,我以为他在向我招手,结果他其实是在向另一个女孩挥手。

所以为了化解尴尬,我就一直把手举着,结果一辆出租车停下來,载我到机场,现在我已经在波兰开始新的生活了。

策略

东大:我在等航母,六代机,055,你在等什么? 西大:我啊,我种植了很多的文科杨景媛,在等她们进入大学,考公,进司法机关,别急哦。

荒诞

如果我有罪,请让医务科来惩罚我,而不是拍片时一位老太带着佛牌不摘,说没有携带金属,做核磁的时候飘起来了,跪在地上大喊佛祖显灵了。

剧情

我看过最合理的退队流是男主一行人遇上了能够变形的魔物,男主开外挂识破后主动把变形后的魔物讨伐了,但是没想到魔物留下了一具假尸体,把队友骗了,圣母队长以为他杀了人。第二次又故技重施,就是打算离间主角团,主角也是硬刚圣母队长和心机兽人族男二。结果第三次男主连话都不说直接给魔物霍霍了,展示给队友看,心机男二来了句,鬼知道你是不是为了讨好我们把人的尸体用魔法变成了魔物,毕竟是灭门惨案。男主和圣母队长的关系彻底破裂,于是愤然退队归隐山林

结果下一章,失去了男主的另外三人就吃了大瘪,几乎团灭。连队长的宠物都上阵打架还是没能赢,男二侥幸捡回一条命,跪着求男主原谅和出山

原著有几亿点击量,还拍了真人版电视剧电影和动画,很推荐大家看看。

选择

育儿补贴一年 3600 元,约等于一天 9.9 元,外卖补贴 18.8 元一天,选哪个不用我多说了吧。

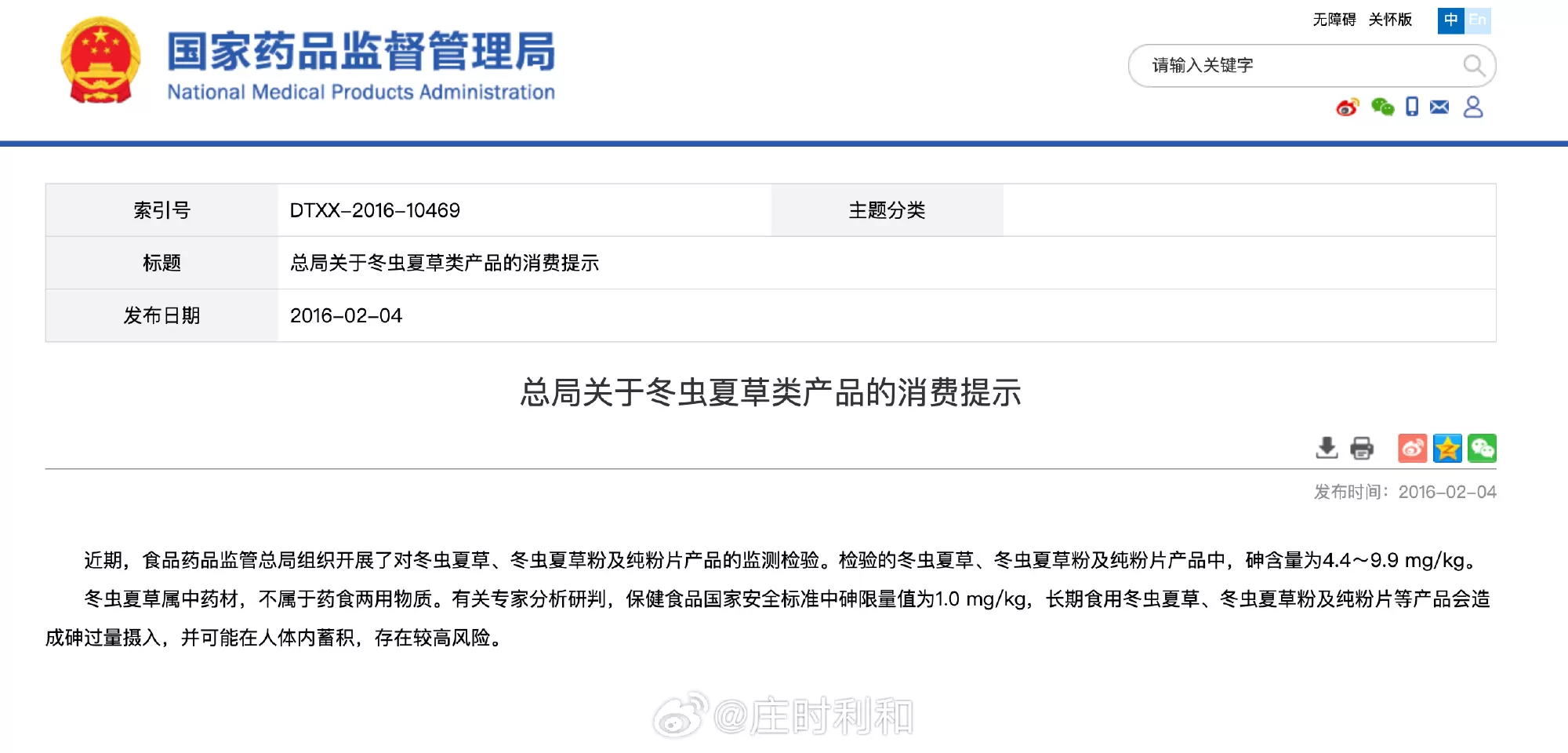

原来还有不少朋友不知道,冬虫夏草早就被踢出保健品名单了

@ 庄时利和: 原来还有不少朋友不知道,冬虫夏草早就被踢出保健品名单了。

原因是冬虫夏草在生长过程中会富集砷,吃多了有砷中毒的风险,所以你家里所有的冬虫夏草产品无论多贵,都可以直接当做垃圾扔了。

至于认为吃了冬虫夏草有什么神奇功效,那纯属一厢情愿。在过去几十年,由于论文审批的宽松,导致一大批莫名其妙的玩意儿借着这些劣质论文上市,重灾区是多糖类皂苷类啥的,抓几个老鼠做实验,整一些有效数据就能发论文,论文水平不如今天医学院本科生大三的开题论文。

冬虫夏草当年也是一堆研究,都是先射箭后画靶子的研究。比如最早认为它有效是因为其中的虫草酸,结果后来发现所谓的虫草酸就是甘露醇,医院里面几块钱一大瓶的那种;这条路走不通之后又鼓吹里面的虫草素,结果进一步研究发现冬虫夏草里面没法检测出虫草素。

多说一句,即便虫草素有某种程度的抗癌之效,想通过吃这玩意的方法抗癌,那跟你往太平洋里面扔一个鸡蛋然后说请美国人民喝紫菜蛋花汤没啥区别。

保健品的审批门槛比药品低不少,冬虫夏草连保健品的门槛都够不上。

下半年市场不乐观的话,春节就是大逃杀了

@ 海哥创业圈: 昨天约了几个做实体连锁店的圈友吃饭,有医美、大健康、教育、运动等。

各位圈友普遍都反应最近生意不好做,尤其从 5、6 月份开始遇到了传统淡季,叠加经济下滑周期,觉得这几个月能熬下去不亏就不错了。

- 平台几乎没有自然流,小红书对这些商业类目都卡的很死,美团投流费用巨贵,像医美一个点击就是 50 元钱。

- 转化效率低,有个做医美的圈友,某平台给他了 70 多个号称平台 VIP 客户,结果只成交了一单,价格 300 元。

- 客单价降低了 3 成左右,高客单的现在基本买不动,引流过的基本上都是薅羊毛的,整体消费都在降级。

- 市场虽然这么难,但是还是有不少新人入场进来卷,不少都是跨行选手,真不知道他们哪里来的勇气,导致竞争依然很卷。

少部分人享福,大部分人吃苦

@ 阿尔法虎虎: 这个世界的运行规则是,少部分人享福,大部分人吃苦。

所以真正重要的是,如何成为那少部分人,而不是刻舟求剑地模仿,过往的 “少部分人” 都做过些什么。

曾经住破房子的人,后来成了拆迁户大佬;曾经买房早的人,后来增值数十倍;曾经下海摆地摊的人,掘金发家;曾经的普通厂工人,现在领到了体面的退休金;曾经上岸体制的老人,现在成了顶流退休人员;曾经的 985 学历证书,做题家逆袭中产。

让那些人过上好日子的归因,并不是住了几十年破房子、早点买房、有勇气下海、努力交城市社保、上岸、考取学历证书,而是 TA 的行为,刚好是每个时代的 “少部分人”。

如果你只是当下时代的 “多数人” 行为,就不要指望顺理成章地能获取上个时代 “少数人” 所享受的红利,哪怕你们在同龄阶段做了相同的事。

没有普惠,只有分化,这是世界运行的客观规律。

那些指着过去如何如何,让你认为你只要那样那样,未来也可以拥有这样这样,这种线性外推,是一种幻术。

你甘愿把上个时代的 “代价” 重吃一遍,等最后发现没有相同的映射,那时候反正时间已矣,唯有历史的弯路无法缕直。

现在银行业的就业情况

@ 北漂民工的日常: 一个三线城市大行的网友跟我讲了他们市现在银行业的就业情况(有些细节有改动)。

一个岗位报录比 300:1,进面试的差不多 10:1,早年全日制本科就行,现在要求 985、211 了,主要是投简历的应届生太多了,像市行里面,基本上已经要求 985 本硕了,如果是偏远县的网点,就松得多,而且反而不要研究生,因为留不住,嫌银行工资低,一边干着一边考公考教师。而且有一种网点特别受欢迎,就是里市区不远的县的网点,很多人都是住市区,然后开车十公里就可以到周边县的网点,上下班很方便,县的网点要求相对低,好进,市区的网点太难进了。

现在的问题是,一方面人太多了,一方面流动性大又留不住人才,可能培养了两年,人家一下子考公就上岸了,不干了。最后发现 985 的本科生最好用,现在本科生出去不好找工作,985 的娃又聪明又好用,以后网点都招 985 本科生!

他还给我讲了个好玩的事情,他堂弟家孩子今年也是考银行,那个岗位也是只招一个人,面试后排第三名,本来以为没戏了,结果第一名拿了更好的 offer 放弃了,第二名考上公务员也不来了,这娃就递补上了,柳暗花明又一村啊。现在正在封闭式集中培训,过段时间就可以出来卖保险理财基金了。

你就说,有没有发现现在银行的年轻人都特别优秀?毕竟你家附近网点的桂圆,可能都是几百人里面卷出来的独苗苗,能不优秀吗?

我们毕业的时候银行和四大基本上是保底工作,实在不行了,去银行搞个管培生吧,去四大加班吧。现在形势逆转了,本科生能去银行,已经是人中龙凤。不过四大不清楚是什么情况,我毕业后基本上和四大的同学们就失联了,可能一直忙着加班吧。

如果 AI 不能继续变聪明了,我们该怎么办

@ 阑夕: GPT-5 发布之后,「纽约客」刊出一篇长文评论,充满了这本杂志特有的那种讽刺味儿,就差没把「眼见他起高楼,眼见他宴宾客,眼见他楼塌了」写到脸上了,我手搓翻译了全文,作为睡前读物给你们感受一下。

如果 AI 不能继续变聪明了,我们该怎么办 – by Cal Newport

所有和 AI 相关的兴奋和焦虑,源头都能追溯到 2020 年的 1 月。

当时,OpenAI 的研究团队发布了一份 30 页的技术报告,题为「神经语言模型的扩展规律」(Scaling Laws for Neural Language Models),撰写者包括后来创办了 Anthropic 的 Dario Amodei,他们试图摸清一个生僻却重要的问题:如果持续增强语言模型的训练规模,它的性能会发生怎样的变化?

那会儿绝大多数机器学习的专家都认为,语言模型达到一定规模后就会开始背题,从而在实际交互中变得不太可用。

但是 OpenAI 的这篇论文提出了截然相反的判断:语言模型越大,智力就会越高,甚至可以说,这种进化可能遵循类似「幂率分布」的法则,呈现出一条类似曲棍球棒的上升曲线。

换句话说,只要不断构建更大规模的语言模型,并用更大的数据集进行训练,那么模型就会一直变强下去。几个月后,OpenAI 发布了 GPT-3,它的规模是 GPT-2 的十倍,性能也大幅提高,似乎验证了「扩展定律」(Scaling Laws)的存在。

一夜之间,那种曾被视为遥不可及的通用人工智能(AGI)—— 在各项任务里都能表现得和人类一样好 —— 似乎近在咫尺了,如果「扩展定律」成立,AI 公司只要向语言模型不断投入资金和算力就能实现通用人工智能。

随后一年里,Sam Altman 发布了一篇题为「万物摩尔定律」的博客文章,认为 AI 将接管人类从事的一般向工作,并为持有资本的人创造难以想象的财富。

他是这么写的:「这场技术革命不可阻挡。世界将发生剧烈变化,我们也必须进行同样剧烈的政策调整,才能公平分配这些财富,并让更多人过上他们想要的生活。」

「扩展定律」必将通向通用人工智能,这成了 AI 界的信仰。2022 年,纽约大学心理与神经科学教授 Gary Marcus 对 OpenAI 的那篇论文提出批评,认为「扩展定律」只是一个观察的结果,而非引力这种客观规律。

这下子 Gary Marcus 捅了马蜂窝,据他所说,自己从来没有因为写了一篇文章而被那么多声名显赫的大佬嘲笑过,从 Sam Altman、Greg Brockman 到 Yann LeCun、Elon Musk,这种待遇实际上把他从机器学习这个圈子里驱逐了出去。

后来发生的故事大家都很熟悉了,ChatGPT 成为了史上用户增长最快的产品,2023 年 3 月,GPT-4 的发布让 AI 性能的提高变得匪夷所思,以致于微软专门为此新写了一篇论文,标题是梦幻般的「通用人工智能的火花」,在接下来的一年里,涌入 AI 行业的风险投资增加了 8 成。

然而,进展的放缓同样来得猝不及防。GPT-4 后的 2 年多时间里,OpenAI 没有发布跨代际的模型,改为专注于一些专业化的版本更新,让普通人难以跟进,业内也开始有声音质疑「扩展定律」的失效。

OpenAI 的联合创始人 Ilya Sutskever 去年曾对路透社表示:「2010 年代是扩展的年代,现在我们又回到了探索与发现的年代,大家都在寻找下一个突破点。」

同时期在 TechCrunch 发布的一篇报道也透露了这种变得普遍起来的情绪:「如今大家好像又承认了,单靠更多的算力和数据来训练模型不能造出一个全知全能的赛博之神。」

不过,这些声音很多时候还是会被那些更为惊人的头条新闻淹没掉,像是 Dario Amodei 认为「AI 几乎已经在所有的智力型任务上超过人类,未来五年内至少会有一半的初级文职工作会被代替」,而 Sam Altman 和 Mark Zuckerberg 都在今年夏天宣称距离开发出「超级智能」只差临门一脚。

就在上周,OpenAI 终于发布了 GPT-5,所有人都期待它能带来 AI 能力的又一次重大飞跃。在早期评测中,一些表选确实可圈可点。

比如科技博主 Mrwhosetheboss 要求 GPT-5 创建一款以宝可梦作为棋子的国际象棋之后,得到的结果很明显比 GPT-4 mini-high 要好,他还发现 GPT-5 能为他的 YouTube 频道写出比 GPT-4o 更优秀的脚本,但他也意识到,GPT-4o 依然能在生成图片的技能上打败 GPT-5,而且 GPT-5 也不是完全没有幻觉。

几小时内,Reddit 的 r/ChatGPT 版块里就充满了失望的氛围,一个贴子把 GPT-5 称作「史上最垃圾的付费产品」,在一次 AMA 问答里,前来做客的 Sam Altman 和 OpenAI 的其他工程师全程处于挨批的位置,不得不回应各种尖锐之辞。

Gary Marcus 终于舒服了,他给 GPT-5 的发布会盖棺定论:姗姗来迟、炒作过度、失望透顶。

GPT-5 的问世让人们很难再去相信 AI 界的夸张预测,反而让 Gary Marcus 这样的批评者变得温和起来。他们认为 AI 固然重要,但不会很快改变我们现有的生活,大家应该接受现实,那就是 AI 在短期内不可能变得更好了。

OpenAI 不是故意等了将近 2 年半的时间才发布 GPT-5 的,根据 The Information 的报道,去年春天,Sam Altman 就告诉员工下一代模型 —— 代号「猎户座」—— 将明显优于 GPT-4。然而,到了秋天,事情就变得不那么乐观了:「尽管新模型的表现的确超过了前代,但相比 GPT-3 到 GPT-4 的飞跃,这次的提升幅度要小得多。」

「猎户座」的失利加剧了那种日益蔓延的怀疑:「扩展定律」并非真的定律。如果构建越来越大的模型所产生的回报开始递减,AI 公司就需要新的策略来训练它们的模型产品。

很快的,AI 公司将目光转向了「后训练」(Post-Training Improvements)。语言模型通常先要经过「预训练」,也就是通过吸收整个互联网的信息来增强智能。但也可以在此之后继续优化,帮助模型更好的利用已经学会的知识,这就是「后训练」,也被称作强化学习,用来指导模型在特定类型的任务上表现更好,或者教会模型在遇到困难时懂得消耗更多 Tokens 进行解题。

这就好比是造车:「预训练」相当于把车生产出来,「后训练」则是对车辆进行改装。OpenAI 的那篇论文提到过,「预训练」越多,造出来的车就越优秀,如果 GPT-3 是轿车,GPT-4 就是跑车。但当这种进步受阻后,行业里的工作重点就切换到让已有车辆的性能变得更好,科学家也开始做起了技师的活儿。

科技巨头们也迅速的圆润起来,开始对「后训练」寄予厚望,微软的掌门 Satya Nadella 去年表示大家正在看到一个新的「扩展定律」冉冉升起,投资者 Anjney Midha 也表示「扩展定律」的第二条命启动了。

很快,OpenAI 于去年年底发布了 o1,通过「后训练」为模型赋予了推理和编程能力,随即又连续发布了 o3-mini、o3-mini-high、o4-mini、o4-mini-high 和 o3-pro,每个模型都采用了量身定制的「后训练」组合。

同行也都在做出类似的转身。Anthropic 在今年 2 月发布的 Claude 3.7 Sonnet 里尝试了「后训练」改进方法,并将其作为 Claude 4 系列模型的核心。

Elon Musk 的 xAI 在 Grok 3 之前仍在追求「扩展定律」,其在训练时消耗了惊人的 10 万块 H100 芯片 —— 这比 GPT-4 高出好几倍 —— 但当 Grok 3 依然没能显著超过竞争对手后,xAI 也选择了「后训练」来开发 Grok 4。

GPT-5 可以说是这种发展轨迹的延续,它更像是对一系列「后训练」产品的整合,而不是一款脱胎换骨的全新模型。

那么问题来了,新的方法能否让我们重返 AGI 之路?OpenAI 在 GPT-5 的发布中展示了几十张图表,用于量化模型在多语种编程、多模态推理等领域的进步,这没毛病,但我们都还记得,GPT-4 的发布时可不需要这么多的图表,每个人使用几分钟后就能感受到它是多么不可思议的创造。

部分基准测试本身也值得怀疑。自从 o1 问世,AI 公司就在宣传推理模型的意义。但在今年 6 月,苹果发布了一篇论文「思维的错觉」(The Illusion of Thinking),发现所谓先进的推理模型在任务复杂度超过一定阈值后,便会产生性能崩溃的现象,从 o3-mini、到 Claude 3.7 Sonnet 以及 DeepSeek-R1,无一幸免。

上周,亚利桑那州立大学的研究团队得出了一个更直白的结论:推理能力是一种假象,一旦出题超过训练范围就会迫使模型宕机,而且在测试题库里拿到高分,和真正解决现实问题之间,存在着巨大的鸿沟。

Gary Marcus 还在幸灾乐祸:「我没听到哪家公司会说 2025 年的模型比 2024 年的模型更好用,测试的分数可不能拿来提高工作效率。」是的,把你的凯美瑞开进改装店可以带来很大的性能提升,但再怎么改,它也变不成法拉利。

我让包括 Gary Marcus 在内的几个怀疑论者预测 AI 在未来几年能对经济产生多大的影响,其中一个科技分析师 Ed Zitro 断言 AI 只是一个 500 亿美金的市场,而非万亿级别,Gary Marcus 说得更刺耳,「好的话是 500 亿,不好的话也就 100 亿。」

语言学教授 Emily Bender 则说,「市场的大小取决于有多少管理层会被这项技术蒙蔽双眼,并改造工作岗位,这样的情况越普遍,普通人的处境也就越糟糕。」

他们的观点过去常被当作是「落伍的老头儿老太太们对着天上的云朵哈气」—— 这来自一条真实的推文评论 —— 公众更加愿意倾听科技公司的宏大愿景。或许,这种局面正在扭转。

如果他们对于 AI 的悲观预测是对的,那么未来会以渐进而非突变的方式降临,很多人会用 AI 来查询信息、撰写报告,编程和学术等领域可能会走得稍微快一点,少数职业 —— 比如配音、文案 —— 基本消失,但 AI 未必会彻底扰乱整个就业市场,而「超级智能」这样的夸张概念也不会再有太大的信徒市场。

继续买单 AI 这件事情或许也有危险。目前,美股总市值里大概有 35% 都集中在 7 巨头身上,这关联到很多人的养老金,而 7 巨头在过去 18 个月里总计往 AI 砸进了 5600 亿美金的资本支出,而收入却只有 350 亿,这太疯狂了。

不过,即使是温和派,也在提醒人类不要就此过于轻视 AI。Gary Marcus 讨厌语言模型,但他也相信,通过别的技术路线,通用人工智能还是有机会在 2030 年实现。趁着这段喘息期,人类应当提前做好准备,制定有效的监管措施,想清楚伦理问题。

对了,在 OpenAI 那篇关于「扩展定律」的论文附录里,有一个「注意事项」的篇章,后来的报道往往忽略了此处。作者写道:「目前我们并没有得出完善的理论体系,模型规模和算力供给之间的扩展关系非常神秘。」事实证明,「扩展定律」有时有效,有时无效,终究不是铁律,而教会机器学会思考这一事业,仍然充满谜团。

我们是该少一些傲慢,多一些谨慎。

文章不错哦

文章不错哦